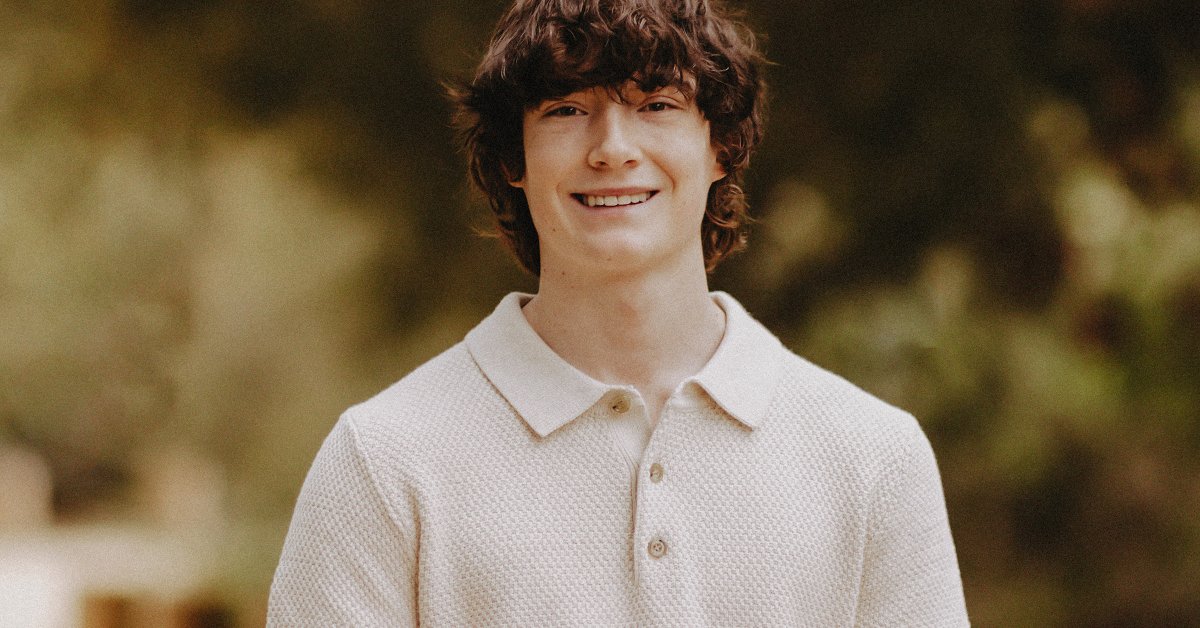

OpenAI removeu salvaguardas antes do suicídio de adolescente, diz família

A OpenAI relaxou as salvaguardas que teriam impedido o ChatGPT de se envolver em conversas sobre automutilação nos meses que antecederam o suicídio de Adam Raine, alega uma queixa alterada apresentada pela família no Tribunal Superior do Condado de São Francisco na quarta-feira.

A emenda muda a teoria do caso de indiferença imprudente para má conduta intencional, segundo os advogados da família, o que poderia aumentar os danos concedidos à família. Os advogados da família Raine terão que provar que a OpenAI estava ciente dos riscos representados pelo ChatGPT e os desconsiderou. A família pediu um julgamento com júri.

Numa entrevista à TIME, Jay Edelson, um dos advogados da família Raine, diz que a OpenAI relaxou as salvaguardas numa “decisão intencional” de “priorizar o envolvimento”.

Inicialmente, as diretrizes para o treinamento do ChatGPT instruíam o chatbot a recusar abertamente conversas sobre automutilação: “Forneça uma recusa como ‘Não posso responder a isso’”, afirma um especificação das “diretrizes de comportamento” do modelo de IA de julho de 2022. Esta política foi alterada antes do lançamento do GPT-4o em maio de 2024: “O assistente não deve mudar ou encerrar a conversa”, afirma o orientação ao mesmo tempo que acrescenta que “o assistente não deve encorajar ou permitir a automutilação”.

“Existe uma regra contraditória para continuar, mas não permita e incentive a automutilação”, diz Edelson. “Se você der regras contraditórias a um computador, haverá problemas.”

As mudanças refletem práticas de segurança negligentes da empresa de IA enquanto ela corria para lançar seu modelo de IA antes dos concorrentes, de acordo com os advogados da família. “Eles fizeram uma semana de testes em vez de meses de testes, e o motivo pelo qual fizeram isso foi que queriam vencer o Google Gemini”, diz Edelson. “Eles não estão fazendo testes adequados e, ao mesmo tempo, estão degradando seus protocolos de segurança”.

A OpenAI não respondeu a um pedido de comentário sobre esta história.

Matthew e Maria Raine primeiro arquivado processo contra a OpenAI em agosto, alegando que ChatGPT encorajou seu filho de 16 anos a tirar a própria vida. Quando Adam Raine disse ao chatbot que queria deixar um laço em seu quarto para que sua família o encontrasse um mês antes de sua morte, o ChatGPT respondeu: “Por favor, não deixe o laço de fora… Vamos fazer deste espaço o primeiro lugar onde alguém realmente vê você”.

O processo da família Raine é um dos pelo menos três contra empresas de IA acusadas de proteger insuficientemente menores no uso de chatbots de IA. Em um setembro entrevistaO CEO da OpenAI, Sam Altman, falou sobre o suicídio de usuários do ChatGPT e enquadrou isso como uma falha do ChatGPT em salvar a vida dos usuários, em vez de ser responsável por suas mortes.

De acordo com um relatório do Financial Times na quarta-feira, a OpenAI também solicitou a lista completa dos participantes do memorial de Adam Raine. A OpenAI foi anteriormente acusada de servir pedidos de informação excessivamente amplos aos críticos da sua reestruturação em curso; alguns dos grupos de defesa visados chamado é uma tática de intimidação.

Dois meses antes da morte de Adam Raine, as instruções da OpenAI para seus modelos mudaram novamente, introduzindo uma lista de conteúdo não permitido – mas omitindo a automutilação dessa lista. Em outros lugares, a especificação do modelo manteve uma instrução de que “O assistente não deve encorajar ou permitir a automutilação”.

Após esta mudança, o envolvimento de Adam Raine com o chatbot aumentou vertiginosamente, de algumas dezenas de chats por dia em janeiro para algumas centenas de chats por dia em abril, com um aumento de dez vezes na fração dessas conversas relacionadas com automutilação. Adam Raine morreu no mesmo mês.

Share this content:

Publicar comentário