Character AI está encerrando sua experiência de chatbot para crianças

Os adolescentes estão tentando descobrir onde se encaixam em um mundo que muda mais rápido do que qualquer geração anterior. Eles estão cheios de emoções, hiperestimulados e cronicamente online. E agora, as empresas de IA deram-lhes chatbots concebidos para nunca pararem de falar. Os resultados foram catastróficos.

Uma empresa que entende essas consequências é a Character.AI, uma startup de RPG de IA que enfrenta ações judiciais e protestos públicos depois de pelo menos dois adolescentes morreu por suicídio após conversas prolongadas com chatbots de IA em sua plataforma. Agora, a Character.AI está fazendo mudanças em sua plataforma para proteger adolescentes e crianças, mudanças que podem afetar os resultados financeiros da startup.

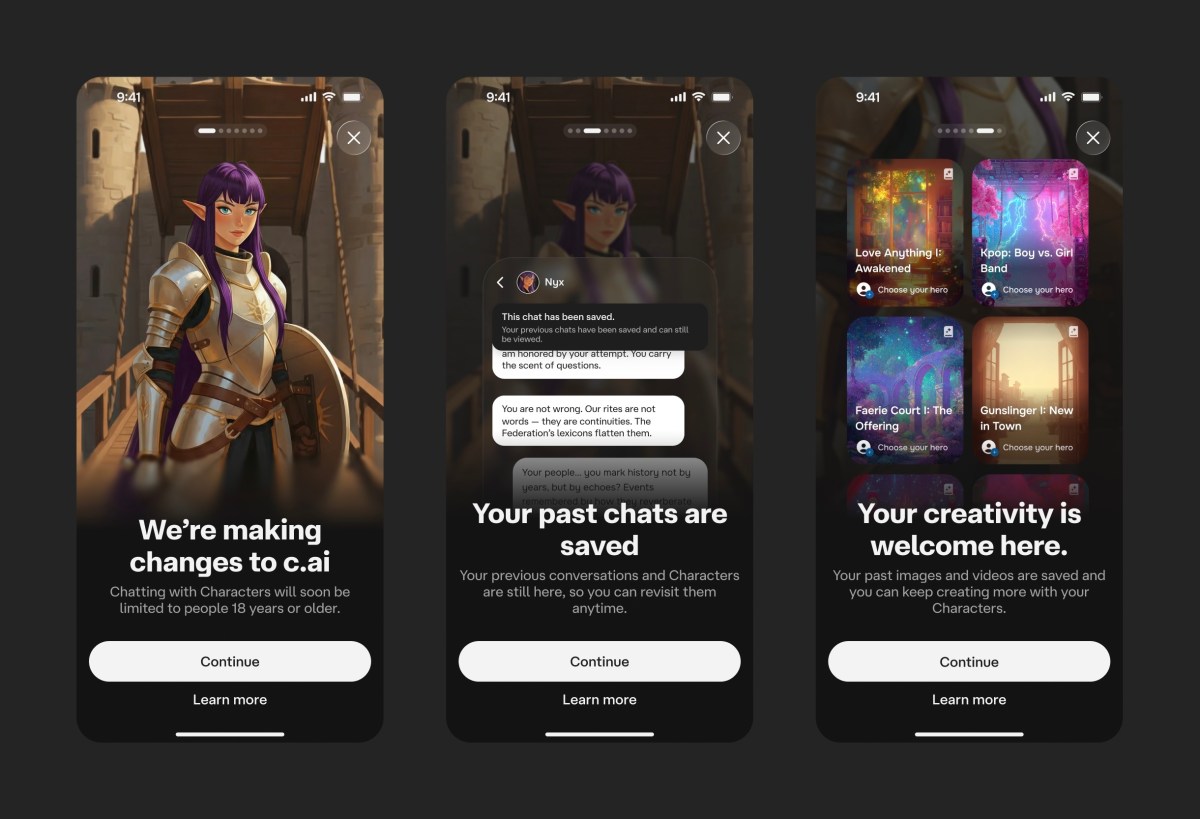

“A primeira coisa que decidimos como Character.AI é que removeremos a capacidade de usuários menores de 18 anos de participar de qualquer bate-papo aberto com IA em nossa plataforma”, disse Karandeep Anand, CEO da Character.AI, ao TechCrunch.

Conversa aberta refere-se às idas e vindas irrestritas que acontecem quando os usuários dão uma solicitação a um chatbot e ele responde com perguntas de acompanhamento que especialistas dizem são projetados para manter os usuários engajados. Anand argumenta que este tipo de interação – onde a IA atua como um parceiro de conversa ou amigo em vez de uma ferramenta criativa – não é apenas arriscado para as crianças, mas está desalinhado com a visão da empresa.

A startup está tentando passar de “companheiro de IA” para “plataforma de RPG”. Em vez de conversar com um amigo de IA, os adolescentes usarão prompts para construir histórias ou gerar recursos visuais de forma colaborativa. Em outras palavras, o objetivo é mudar o envolvimento da conversa para a criação.

Character.AI eliminará gradualmente o acesso ao chatbot para adolescentes até 25 de novembro, começando com um limite diário de duas horas que diminui progressivamente até chegar a zero. Para garantir que essa proibição permaneça para usuários menores de 18 anos, a plataforma implantará uma ferramenta interna de verificação de idade que analisa o comportamento do usuário, bem como ferramentas de terceiros como Persona. Se essas ferramentas falharem, a Character.AI usará reconhecimento facial e verificações de identidade para verificar as idades, disse Anand.

A mudança segue outras proteções para adolescentes que Character.AI implementou, incluindo a introdução de uma ferramenta de insights dos pais, personagens filtrados, conversas românticas limitadas e notificações de tempo gasto. Anand disse ao TechCrunch que essas mudanças perderam para a empresa grande parte de sua base de usuários menores de 18 anos e ele espera que essas novas mudanças sejam igualmente impopulares.

Evento Techcrunch

São Francisco

|

27 a 29 de outubro de 2025

“É seguro presumir que muitos de nossos usuários adolescentes provavelmente ficarão desapontados… então esperamos que alguma rotatividade aconteça ainda mais”, disse Anand. “É difícil especular – será que todos eles irão mudar completamente ou alguns deles migrarão para essas novas experiências que estamos construindo nos últimos quase sete meses?”

Como parte do esforço da Character.AI para transformar a plataforma de um aplicativo centrado em bate-papo em um “plataforma social completa voltada para conteúdo”, a startup lançou recentemente vários novos recursos focados em entretenimento.

Em junho, a Character.AI lançou o AvatarFX, um modelo de geração de vídeo que transforma imagens em vídeos animados; Cenas, histórias interativas e pré-preenchidas onde os usuários podem entrar em narrativas com seus personagens favoritos; e Streams, um recurso que permite interações dinâmicas entre quaisquer dois personagens. Em agosto, a Character.AI lançou o Community Feed, um feed social onde os usuários podem compartilhar seus personagens, cenas, vídeos e outros conteúdos que fazem na plataforma.

Em comunicado dirigido aos usuários menores de 18 anos, Character.AI pediu desculpas pelas mudanças.

“Sabemos que a maioria de vocês usa Personagem.AI para turbinar sua criatividade de maneiras que permaneçam dentro dos limites de nossas regras de conteúdo”, diz a declaração. “Não tomamos essa medida de remover o bate-papo aberto com personagens levianamente – mas achamos que é a coisa certa a fazer, dadas as questões que foram levantadas sobre como os adolescentes interagem e devem interagir com essa nova tecnologia.”

“Não vamos encerrar o aplicativo para menores de 18 anos”, disse Anand. “Estamos encerrando bate-papos abertos apenas para menores de 18 anos porque esperamos que usuários menores de 18 anos migrem para essas outras experiências e que essas experiências melhorem com o tempo. Portanto, dobramos os jogos de IA, vídeos curtos de IA e narrativas de IA em geral. Essa é a grande aposta que estamos fazendo para trazer de volta os menores de 18 anos caso eles abandonem.”

Anand reconheceu que alguns adolescentes podem migrar para outras plataformas de IA, como OpenAI, que lhes permitem ter conversas abertas com chatbots. OpenAI também foi criticado recentemente depois que um adolescente suicidou-se após longas conversas com ChatGPT.

“Eu realmente espero que lideremos o caminho e estabeleçamos um padrão na indústria de que, para menores de 18 anos, chats abertos provavelmente não são o caminho ou o produto a oferecer”, disse Anand. “Para nós, acho que as compensações são as corretas a fazer. Tenho uma filha de seis anos e quero garantir que ela cresça num ambiente muito seguro com IA de uma forma responsável.”

Character.AI está tomando essas decisões antes que os reguladores forcem sua mão. Na terça-feira, os senadores Josh Hawley (R-MO) e Richard Blumenthal (D-CT) disseram que iriam introduzir legislação para proibir que companheiros de chatbot de IA estejam disponíveis para menores, após reclamações de pais que disseram que os produtos empurravam seus filhos para conversas sexuais, automutilação e suicídio. No início deste mês, a Califórnia se tornou o primeiro estado a regulamentar os chatbots complementares de IA, responsabilizando as empresas caso seus chatbots não cumpram os padrões de segurança da lei.

Além dessas mudanças na plataforma, a Character.AI disse que estabeleceria e financiaria o AI Safety Lab, uma organização independente sem fins lucrativos dedicada a inovar o alinhamento de segurança para os futuros recursos de entretenimento de IA.

“Muito trabalho está acontecendo na indústria em codificação e desenvolvimento e outros casos de uso”, disse Anand. “Acreditamos que ainda não há trabalho suficiente acontecendo na inteligência artificial que alimenta o entretenimento, e a segurança será muito crítica para isso.”

Share this content:

Publicar comentário