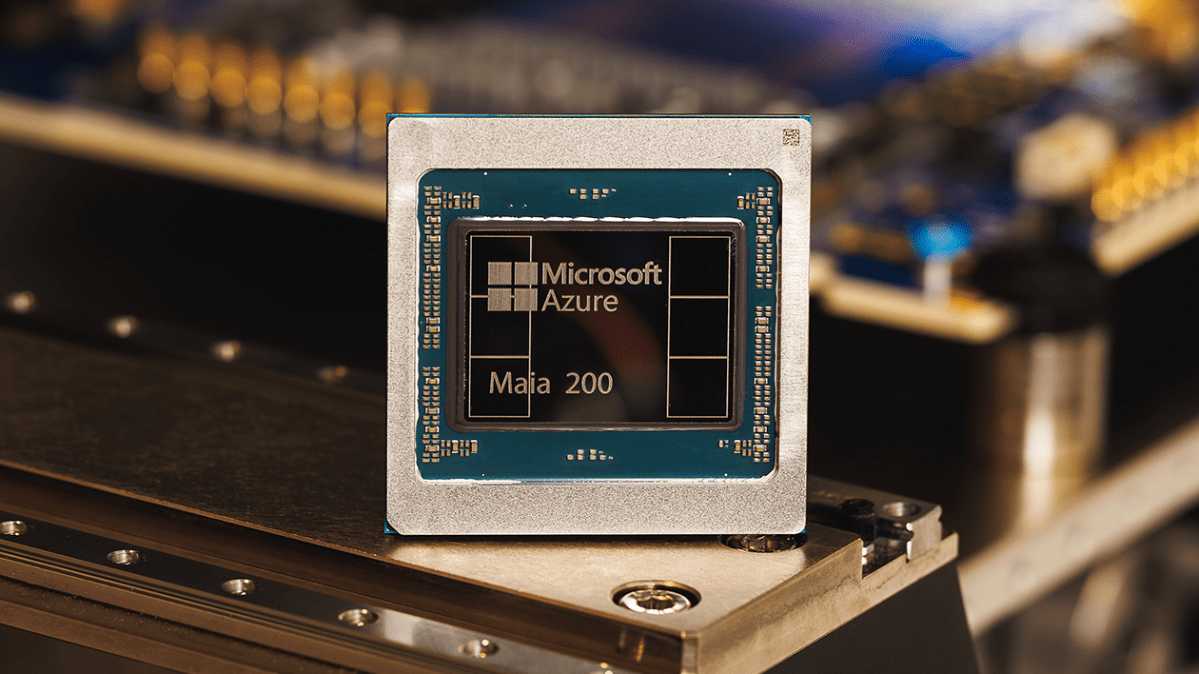

Microsoft anuncia novo e poderoso chip para inferência de IA

A Microsoft anunciou o lançamento de seu mais recente chip, o Maia 200, que a empresa descreve como um burro de carga de silício projetado para dimensionar a inferência de IA.

O 200, que segue a trajetória da empresa Maia 100 lançado em 2023foi tecnicamente equipado para executar modelos poderosos de IA em velocidades mais rápidas e com mais eficiência, disse a empresa. Maia vem equipado com mais de 100 bilhões de transistores, fornecendo mais de 10 petaflops com precisão de 4 bits e aproximadamente 5 petaflops de desempenho de 8 bits – um aumento substancial em relação ao seu antecessor.

Inferência refere-se ao processo computacional de execução de um modelo, em contraste com a computação necessária para treiná-lo. À medida que as empresas de IA amadurecem, os custos de inferência tornaram-se uma parte cada vez mais importante dos seus custos operacionais globais, levando a um interesse renovado em formas de optimizar o processo.

A Microsoft espera que o Maia 200 possa fazer parte dessa otimização, fazendo com que os negócios de IA funcionem com menos interrupções e menor consumo de energia. “Em termos práticos, um nó Maia 200 pode executar facilmente os maiores modelos atuais, com bastante espaço para modelos ainda maiores no futuro”, disse a empresa.

O novo chip da Microsoft também faz parte de uma tendência crescente de gigantes da tecnologia que recorrem a chips autoprojetados como forma de diminuir sua dependência da NVIDIA, cujo GPUs de última geração tornaram-se cada vez mais essenciais para o sucesso das empresas de IA. O Google, por exemplo, tem suas TPU, as unidades de processamento de tensores – que não são vendidas como chips, mas à medida que o poder computacional se torna acessível por meio de sua nuvem. Depois, há o Amazon Trainium, o chip acelerador de IA da própria gigante do comércio eletrônico, que acaba de lançar sua versão mais recenteo Trainium3, em dezembro. Em cada caso, as TPUs podem ser usadas para descarregar parte da computação que, de outra forma, seria atribuída às GPUs NVIDIA, diminuindo o custo geral de hardware.

Com Maia, a Microsoft se posiciona para competir com essas alternativas. Em seu comunicado à imprensa na segunda-feira, a empresa observou que Maia oferece 3x o desempenho do FP4 dos chips Amazon Trainium de terceira geração e desempenho do FP8 acima do TPU de sétima geração do Google.

A Microsoft diz que Maia já está trabalhando duro para alimentar os modelos de IA da empresa com sua equipe de Superinteligência. Também tem apoiado as operações do Copilot, seu chatbot. Na segunda-feira, a empresa disse que convidou diversas partes – incluindo desenvolvedores, acadêmicos e laboratórios de IA de ponta – para usar seu kit de desenvolvimento de software Maia 200 em suas cargas de trabalho.

Evento Techcrunch

São Francisco

|

13 a 15 de outubro de 2026

Share this content:

Publicar comentário