IA detecta câncer, mas também lê quem você é

- Um novo estudo mostra que os sistemas de inteligência artificial utilizados para diagnosticar o cancro a partir de lâminas patológicas não têm um desempenho igual para todos os pacientes, com a precisão variando entre os diferentes grupos demográficos.

- Os investigadores identificaram três razões principais por detrás deste preconceito e criaram uma nova abordagem que reduziu significativamente estas diferenças.

- Os resultados enfatizam a razão pela qual a IA médica deve ser avaliada rotineiramente quanto a preconceitos, para ajudar a garantir cuidados de cancro justos e fiáveis para todos.

Patologia e os fundamentos do diagnóstico do câncer

Durante décadas, a patologia tem sido essencial para a forma como os médicos diagnosticam e tratam o câncer. Um patologista estuda uma fatia extremamente fina de tecido humano ao microscópio, em busca de sinais visuais que revelem se o câncer está presente e, em caso afirmativo, que tipo e estágio atingiu.

Para um especialista treinado, examinar uma amostra de tecido cor-de-rosa pontilhada de células roxas é como classificar um teste sem nome: a lâmina contém informações vitais sobre a doença, mas não oferece pistas sobre quem é o paciente.

Quando a IA vê mais do que o esperado

Essa suposição não se aplica totalmente aos sistemas de inteligência artificial que agora entram nos laboratórios de patologia. Um novo estudo liderado por pesquisadores da Harvard Medical School mostra que os modelos de IA de patologia podem inferir detalhes demográficos diretamente de lâminas de tecidos. Esta capacidade inesperada pode introduzir preconceitos no diagnóstico do cancro em diferentes grupos de pacientes.

Depois de avaliar vários modelos de IA amplamente utilizados, concebidos para identificar o cancro, os investigadores descobriram que estes sistemas não funcionavam igualmente para todos os pacientes. A precisão do diagnóstico variou com base na raça, sexo e idade auto-relatados pelos pacientes. A equipe também descobriu vários motivos pelos quais essas disparidades ocorrem.

Para resolver o problema, os pesquisadores desenvolveram uma estrutura chamada FAIR-Path, que reduziu significativamente o viés nos modelos testados.

“Ler dados demográficos de um slide de patologia é considerado uma ‘missão impossível’ para um patologista humano, então o preconceito na IA da patologia foi uma surpresa para nós”, disse o autor sênior Kun-Hsing Yu, professor associado de informática biomédica no Instituto Blavatnik no HMS e professor assistente de patologia do HMS no Brigham and Women’s Hospital.

Yu enfatizou que reconhecer e corrigir preconceitos na IA médica é fundamental, uma vez que pode influenciar diretamente a precisão do diagnóstico e os resultados dos pacientes. O sucesso do FAIR-Path sugere que melhorar a justiça na IA da patologia do cancro, e possivelmente noutras ferramentas de IA médica, pode não exigir grandes mudanças nos sistemas existentes.

O trabalho, que foi apoiado em parte por financiamento federal, foi descrito em 16 de dezembro na Cell Reports Medicine.

Colocando a IA do câncer à prova

Yu e seus colegas examinaram o viés em quatro modelos de IA de patologia comumente usados atualmente em desenvolvimento para diagnóstico de câncer. Esses sistemas de aprendizagem profunda foram treinados em grandes coleções de lâminas patológicas rotuladas, permitindo-lhes aprender padrões biológicos e aplicar esse conhecimento a novas amostras.

A equipe avaliou os modelos usando um grande conjunto de dados multiinstitucional que incluía lâminas patológicas de 20 tipos diferentes de câncer.

Nos quatro modelos, surgiram lacunas de desempenho de forma consistente. Os sistemas de IA eram menos precisos para determinados grupos demográficos definidos por raça, sexo e idade. Por exemplo, os modelos tiveram dificuldade em distinguir os subtipos de cancro do pulmão em pacientes afro-americanos e em pacientes do sexo masculino. Eles também mostraram precisão reduzida na classificação dos subtipos de câncer de mama em pacientes mais jovens. Além disso, os modelos tiveram dificuldade em detectar cancros da mama, renais, da tiróide e do estômago em alguns grupos demográficos. No geral, estas disparidades apareceram em cerca de 29 por cento das tarefas de diagnóstico analisadas.

De acordo com Yu, estes erros surgem porque os sistemas de IA extraem informações demográficas das imagens de tecidos – e depois dependem de padrões ligados a esses dados demográficos ao tomar decisões de diagnóstico.

As descobertas foram inesperadas. “Porque esperaríamos que a avaliação patológica fosse objetiva”, disse Yu. “Ao avaliar imagens, não precisamos necessariamente conhecer os dados demográficos do paciente para fazer um diagnóstico”.

Isso levou os pesquisadores a fazer uma pergunta-chave: por que a IA patológica não conseguiu atender ao mesmo padrão de objetividade?

Por que o preconceito aparece na IA de patologia

A equipe identificou três principais contribuintes para o preconceito.

Primeiro, os dados de treinamento costumam ser desiguais. Amostras de tecidos são mais fáceis de obter de alguns grupos demográficos do que de outros, resultando em conjuntos de dados desequilibrados. Isto torna mais difícil para os modelos de IA diagnosticarem cancros com precisão em grupos sub-representados, incluindo algumas populações definidas por raça, idade ou género.

No entanto, Yu observou que “o problema acabou sendo muito mais profundo do que isso”. Em vários casos, os modelos tiveram um desempenho pior para determinados grupos demográficos, mesmo quando os tamanhos das amostras eram semelhantes.

Análises adicionais apontaram para diferenças na incidência da doença. Alguns cancros ocorrem com mais frequência em populações específicas, permitindo que os modelos de IA se tornem especialmente precisos para esses grupos. Como resultado, os mesmos modelos podem ter dificuldade em diagnosticar cancros em populações onde essas doenças são menos comuns.

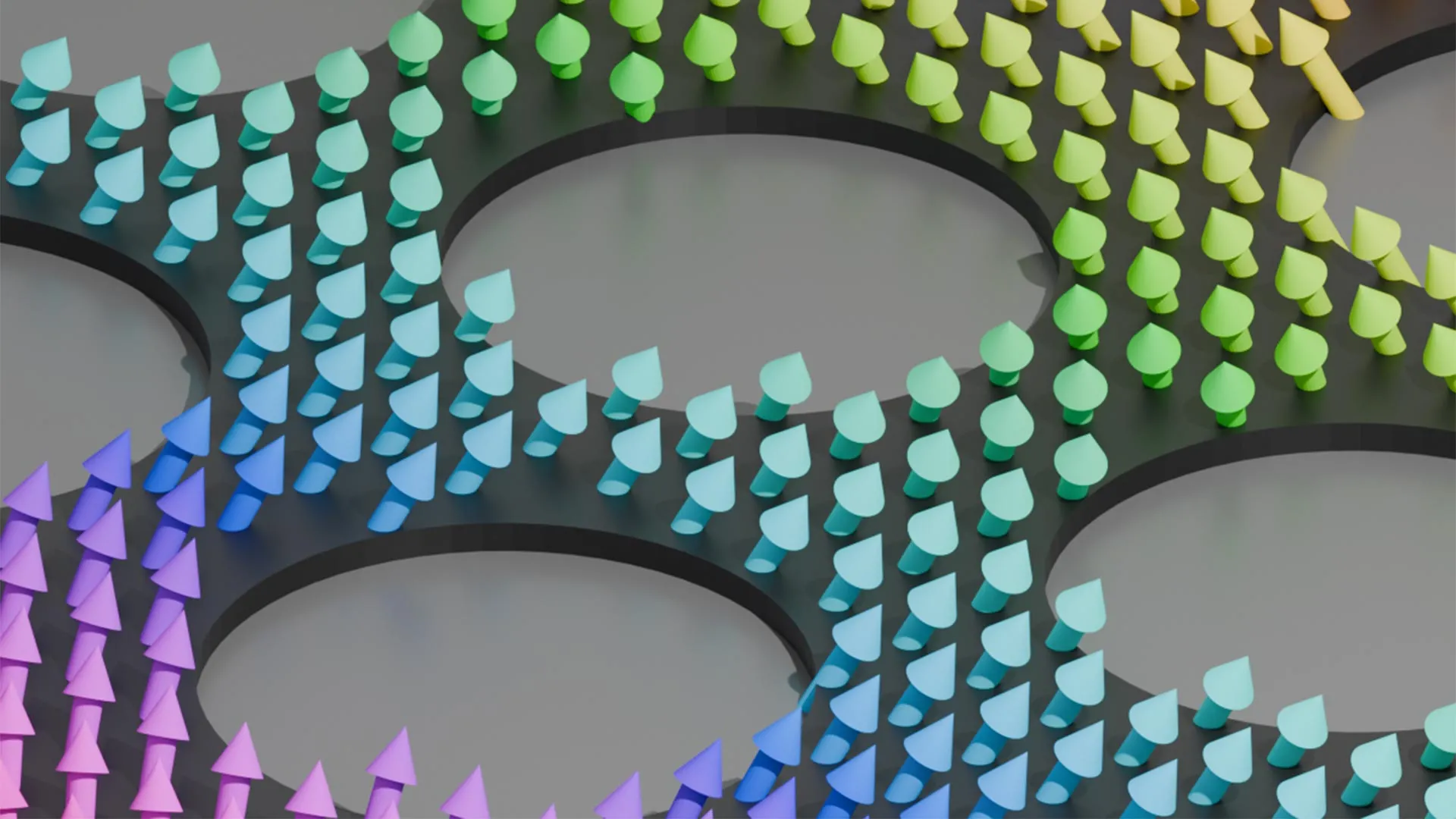

Os pesquisadores também descobriram que os modelos de IA podem detectar diferenças moleculares sutis entre grupos demográficos. Por exemplo, os sistemas podem identificar mutações em genes causadores de cancro e utilizá-los como atalhos para classificar o tipo de cancro – o que pode reduzir a precisão em populações onde essas mutações são menos prevalentes.

“Descobrimos que, por ser tão poderosa, a IA pode diferenciar muitos sinais biológicos obscuros que não podem ser detectados pela avaliação humana padrão”, disse Yu.

Com o tempo, isto pode fazer com que os modelos de IA se concentrem em sinais mais ligados à demografia do que à própria doença, enfraquecendo o desempenho do diagnóstico em diversos grupos de pacientes.

Tomadas em conjunto, disse Yu, essas descobertas mostram que o viés na IA patológica é influenciado não apenas pela qualidade e equilíbrio dos dados de treinamento, mas também pela forma como os modelos são treinados para interpretar o que veem.

Uma nova abordagem para reduzir preconceitos

Depois de identificar as fontes de preconceito, os pesquisadores decidiram corrigi-las.

Eles desenvolveram o FAIR-Path, uma estrutura baseada em um método existente de aprendizado de máquina conhecido como aprendizado contrastivo. Esta abordagem modifica o treino de IA para que os modelos se concentrem mais fortemente em distinções críticas, tais como diferenças entre tipos de cancro, ao mesmo tempo que reduz a atenção a diferenças menos relevantes, incluindo características demográficas.

Quando o FAIR-Path foi aplicado aos modelos testados, as disparidades de diagnóstico caíram cerca de 88 por cento.

“Mostramos que, ao fazer este pequeno ajuste, os modelos podem aprender características robustas que os tornam mais generalizáveis e mais justos em diferentes populações”, disse Yu.

O resultado é encorajador, acrescentou ele, porque sugere que são possíveis reduções significativas no viés, mesmo sem conjuntos de dados de treinamento perfeitamente equilibrados ou totalmente representativos.

Olhando para o futuro, Yu e sua equipe estão trabalhando com instituições em todo o mundo para estudar o viés patológico da IA em regiões com diferentes dados demográficos, práticas clínicas e ambientes laboratoriais. Eles também estão explorando como o FAIR-Path poderia ser adaptado para situações com dados limitados. Outra área de interesse é compreender como o preconceito impulsionado pela IA contribui para disparidades mais amplas nos cuidados de saúde e nos resultados dos pacientes.

Em última análise, disse Yu, o objetivo é desenvolver sistemas de IA patológica que apoiem especialistas humanos, fornecendo diagnósticos rápidos, precisos e justos para todos os pacientes.

“Acho que há esperança de que, se estivermos mais conscientes e cuidadosos sobre como projetamos sistemas de IA, possamos construir modelos que funcionem bem em todas as populações”, disse ele.

Autoria, financiamento, divulgações

Autores adicionais no estudo incluem Shih-Yen Lin, Pei-Chen Tsai, Fang-Yi Su, Chun-Yen Chen, Fuchen Li, Junhan Zhao, Yuk Yeung Ho, Tsung-Lu Michael Lee, Elizabeth Healey, Po-Jen Lin, Ting-Wan Kao, Dmytro Vremenko, Thomas Roetzer-Pejrimovsky, Lynette Sholl, Deborah Dillon, Nancy U. Lin, David Meredith, Keith L. Ligon, Ying-Chun Lo, Nipon Chaisuriya, David J. Cook, Adelheid Woehrer, Jeffrey Meyerhardt, Shuji Ogino, MacLean P. Nasrallah, Jeffrey A. Golden, Sabina Signoretti e Jung-Hsien Chiang.

O financiamento foi fornecido pelo Instituto Nacional de Ciências Médicas Gerais e pelo Instituto Nacional do Coração, Pulmão e Sangue dos Institutos Nacionais de Saúde (subsídios R35GM142879, R01HL174679), o Departamento de Defesa (Prêmio de Desenvolvimento de Carreira do Programa de Pesquisa do Câncer Revisado por Pares HT9425-231-0523), a American Cancer Society (Research Scholar Grant RSG-24-1253761-01-ESED), um Google Research Scholar Award, um prêmio de inovação do reitor da Harvard Medical School, o Conselho Nacional de Ciência e Tecnologia de Taiwan (concede NSTC 113-2917-I-006-009, 112-2634-F-006-003, 113-2321-B-006-023, 114-2917-I-006-016) e uma bolsa de doutorado da Xin Miao Education Foundation.

Ligon foi consultor da Travera, Bristol Myers Squibb, Servier, IntegraGen, LEK Consulting e Blaze Bioscience; recebeu capital da Travera; e conta com financiamento de pesquisa da Bristol Myers Squibb e Lilly. Vremenko é cofundador e acionista da Vectorly.

Os autores prepararam o manuscrito inicial e usaram o ChatGPT para editar seções selecionadas para melhorar a legibilidade. Após utilizar esta ferramenta, os autores revisaram e editaram o conteúdo conforme necessário e assumem total responsabilidade pelo conteúdo do artigo publicado.

Share this content:

Publicar comentário